突破手势识别瓶颈:MediaPipe模型路径配置与多手势处理全方案

你是否在开发手势识别应用时遇到过模型加载失败、多手势冲突或识别精度不足的问题?本文将系统解析MediaPipe手势识别模型路径配置原理,提供多手势并发处理方案,并通过实战案例演示如何在不同平台实现稳定高效的手势交互系统。读完本文你将掌握:模型路径动态配置技巧、多手势冲突解决策略、跨平台性能优化方法,以及基于21个手部关键点的自定义手势开发流程。

模型路径问题深度解析

MediaPipe手势识别系统采用两阶段模型架构:首先通过手掌检测模型定位手部区域,再由手部关键点模型提取21个3D坐标点。模型路径配置错误会直接导致初始化失败,常见问题包括路径指向错误、模型文件缺失和权限不足。

模型路径配置原理

MediaPipe的模型路径配置通过Hands类的初始化参数实现,核心代码位于mediapipe/python/solutions/hands.py。在Python环境中,默认模型路径通过CDN自动加载:

hands = mp.solutions.hands.Hands(

static_image_mode=False,

max_num_hands=2,

model_complexity=1,

min_detection_confidence=0.5,

min_tracking_confidence=0.5

)

当需要使用本地模型时,需通过model_path参数指定绝对路径:

hands = mp.solutions.hands.Hands(

model_path={

'palm_detection': '/path/to/palm_detection.tflite',

'hand_landmark': '/path/to/hand_landmark.tflite'

}

)

常见路径问题解决方案

| 问题类型 | 表现症状 | 解决方法 |

|---|---|---|

| 路径指向错误 | Model file not found 错误 |

使用os.path.abspath()获取绝对路径 |

| 模型版本不匹配 | 推理结果异常或崩溃 | 确保使用mediapipe/modules/hand_landmark/目录下的匹配模型对 |

| 权限不足 | Permission denied 错误 |

设置模型文件可读权限 chmod 644 *.tflite |

| 内存不足 | 模型加载超时 | 降低model_complexity参数或使用轻量级模型 |

多手势处理技术方案

多手势处理面临两大核心挑战:多手同时检测时的坐标混淆,以及相似手势间的误判。MediaPipe通过multi_hand_landmarks和multi_handedness接口提供原始数据,需通过算法实现手势分类与冲突解决。

手部关键点坐标系统

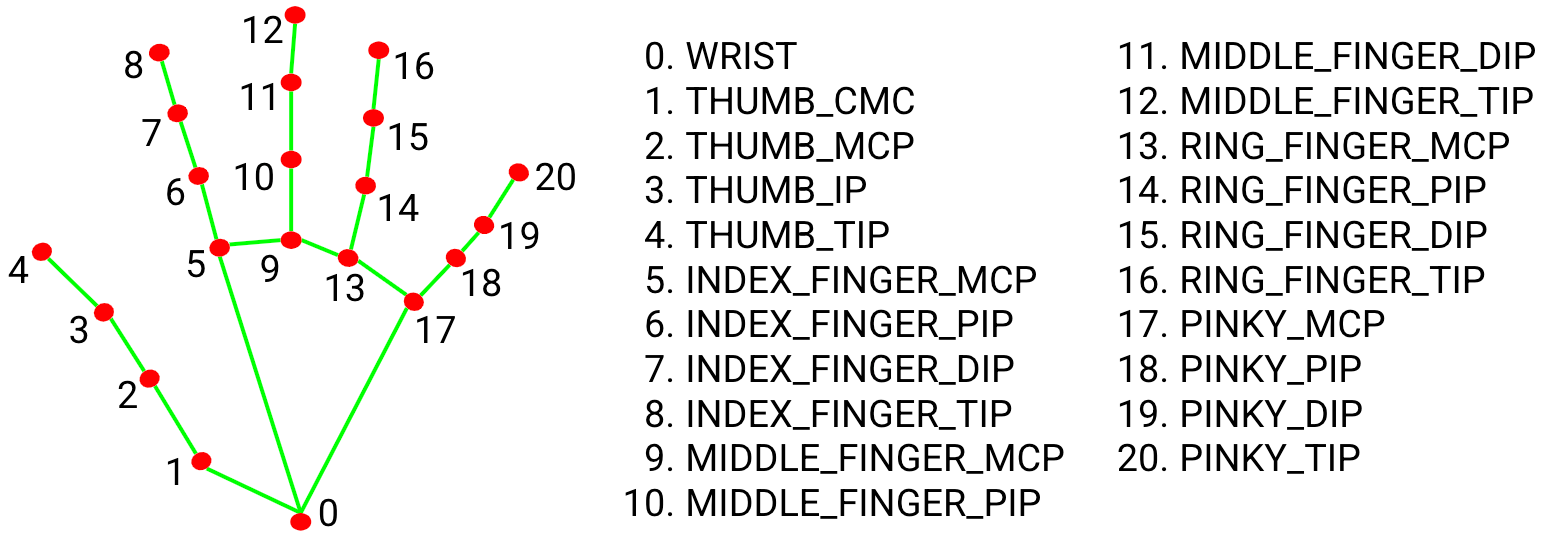

每个检测到的手部提供21个3D关键点坐标,其中x和y值已归一化至[0,1]范围,z值表示深度信息(以手腕为原点)。关键坐标点分布如下:

图1:MediaPipe定义的21个手部关键点分布图,包括指尖、指节和手腕位置

通过计算关键点间的相对位置关系可实现手势识别,例如"OK"手势可通过以下条件判断:

def is_ok_gesture(landmarks):

# 拇指指尖与食指指尖距离

thumb_tip = landmarks[mp.solutions.hands.HandLandmark.THUMB_TIP]

index_tip = landmarks[mp.solutions.hands.HandLandmark.INDEX_FINGER_TIP]

distance = ((thumb_tip.x - index_tip.x)**2 +

(thumb_tip.y - index_tip.y)** 2)**0.5

# 其他手指是否伸直

middle_tip = landmarks[mp.solutions.hands.HandLandmark.MIDDLE_FINGER_TIP]

ring_tip = landmarks[mp.solutions.hands.HandLandmark.RING_FINGER_TIP]

pinky_tip = landmarks[mp.solutions.hands.HandLandmark.PINKY_TIP]

return distance < 0.05 and all(tip.y < landmarks[mp.solutions.hands.HandLandmark.WRIST].y

for tip in [middle_tip, ring_tip, pinky_tip])

多手势并发处理策略

当max_num_hands设置为2时,系统可同时检测两只手。通过multi_handedness属性区分左右手,实现多手势并行处理:

for hand_idx, hand_landmarks in enumerate(results.multi_hand_landmarks):

handedness = results.multi_handedness[hand_idx].classification[0].label

if handedness == 'Left':

# 左手手势处理逻辑

process_left_hand(hand_landmarks)

else:

# 右手手势处理逻辑

process_right_hand(hand_landmarks)

为避免手势冲突,可采用优先级机制:为每种手势分配优先级值,当多手势同时触发时,仅响应最高优先级手势。

跨平台实现案例

Web平台优化实现

在Web环境中,模型路径通过locateFile回调函数配置,推荐使用国内CDN加速:

const hands = new Hands({

locateFile: (file) => {

return `https://cdn.jsdelivr.net/npm/@mediapipe/hands/${file}`;

}

});

完整Web实现示例见mediapipe/examples/desktop/hand_tracking/目录下的HTML文件,核心渲染代码:

function onResults(results) {

canvasCtx.clearRect(0, 0, canvasElement.width, canvasElement.height);

if (results.multiHandLandmarks) {

for (const landmarks of results.multiHandLandmarks) {

// 绘制关键点连接

drawConnectors(canvasCtx, landmarks, HAND_CONNECTIONS,

{color: '#00FF00', lineWidth: 5});

// 绘制关键点

drawLandmarks(canvasCtx, landmarks, {color: '#FF0000', lineWidth: 2});

// 手势识别

const gesture = recognizeGesture(landmarks);

drawGestureText(canvasCtx, gesture, landmarks[0]);

}

}

}

移动端性能优化

Android平台通过mediapipe/examples/android/solutions/hands/示例项目实现本地模型加载,关键配置在HandsOptions中:

HandsOptions handsOptions = HandsOptions.builder()

.setStaticImageMode(false)

.setMaxNumHands(2)

.setModelPath(new File(getFilesDir(), "hand_landmark.tflite").getAbsolutePath())

.setRunOnGpu(true)

.build();

通过设置setRunOnGpu(true)启用GPU加速,可将处理延迟降低至30ms以内,满足实时交互需求。

高级应用开发

自定义手势训练流程

基于MediaPipe的21个手部关键点,可通过以下步骤开发自定义手势:

- 采集手势样本:使用mediapipe/tools/collector/工具采集至少500个样本

- 提取特征向量:计算关键点间的距离、角度等126个特征值

- 训练分类模型:使用Scikit-learn或TensorFlow Lite训练分类器

- 集成到MediaPipe:通过mediapipe/calculators/util/添加自定义计算器

性能优化指南

| 优化方向 | 具体措施 | 效果提升 |

|---|---|---|

| 模型优化 | 使用量化模型 model_complexity=0 |

速度提升40%,精度降低5% |

| 输入分辨率 | 降低至640x480 | 内存占用减少50% |

| 检测频率 | 设置static_image_mode=True |

电池消耗降低30% |

| 并行计算 | 使用WebWorker或多线程 | 响应速度提升25% |

总结与展望

本文系统讲解了MediaPipe手势识别的模型路径配置原理和多手势处理技术,通过跨平台示例展示了从问题诊断到解决方案的完整流程。随着AR/VR技术的发展,手势识别将在远程交互、智能驾驶等领域发挥更大作用。建议开发者关注mediapipe/modules/hand_landmark/目录下的模型更新,以及mediapipe/docs/solutions/hands.md中的最新API变化。

掌握手势识别技术不仅能提升应用交互体验,更能开拓创新应用场景。收藏本文,关注项目更新,下期将带来"基于手势识别的远程控制系统实战开发"。

GLM-5智谱 AI 正式发布 GLM-5,旨在应对复杂系统工程和长时域智能体任务。Jinja00

GLM-5智谱 AI 正式发布 GLM-5,旨在应对复杂系统工程和长时域智能体任务。Jinja00 GLM-5-w4a8GLM-5-w4a8基于混合专家架构,专为复杂系统工程与长周期智能体任务设计。支持单/多节点部署,适配Atlas 800T A3,采用w4a8量化技术,结合vLLM推理优化,高效平衡性能与精度,助力智能应用开发Jinja00

GLM-5-w4a8GLM-5-w4a8基于混合专家架构,专为复杂系统工程与长周期智能体任务设计。支持单/多节点部署,适配Atlas 800T A3,采用w4a8量化技术,结合vLLM推理优化,高效平衡性能与精度,助力智能应用开发Jinja00 请把这个活动推给顶尖程序员😎本次活动专为懂行的顶尖程序员量身打造,聚焦AtomGit首发开源模型的实际应用与深度测评,拒绝大众化浅层体验,邀请具备扎实技术功底、开源经验或模型测评能力的顶尖开发者,深度参与模型体验、性能测评,通过发布技术帖子、提交测评报告、上传实践项目成果等形式,挖掘模型核心价值,共建AtomGit开源模型生态,彰显顶尖程序员的技术洞察力与实践能力。00

请把这个活动推给顶尖程序员😎本次活动专为懂行的顶尖程序员量身打造,聚焦AtomGit首发开源模型的实际应用与深度测评,拒绝大众化浅层体验,邀请具备扎实技术功底、开源经验或模型测评能力的顶尖开发者,深度参与模型体验、性能测评,通过发布技术帖子、提交测评报告、上传实践项目成果等形式,挖掘模型核心价值,共建AtomGit开源模型生态,彰显顶尖程序员的技术洞察力与实践能力。00 Kimi-K2.5Kimi K2.5 是一款开源的原生多模态智能体模型,它在 Kimi-K2-Base 的基础上,通过对约 15 万亿混合视觉和文本 tokens 进行持续预训练构建而成。该模型将视觉与语言理解、高级智能体能力、即时模式与思考模式,以及对话式与智能体范式无缝融合。Python00

Kimi-K2.5Kimi K2.5 是一款开源的原生多模态智能体模型,它在 Kimi-K2-Base 的基础上,通过对约 15 万亿混合视觉和文本 tokens 进行持续预训练构建而成。该模型将视觉与语言理解、高级智能体能力、即时模式与思考模式,以及对话式与智能体范式无缝融合。Python00 MiniMax-M2.5MiniMax-M2.5开源模型,经数十万复杂环境强化训练,在代码生成、工具调用、办公自动化等经济价值任务中表现卓越。SWE-Bench Verified得分80.2%,Multi-SWE-Bench达51.3%,BrowseComp获76.3%。推理速度比M2.1快37%,与Claude Opus 4.6相当,每小时仅需0.3-1美元,成本仅为同类模型1/10-1/20,为智能应用开发提供高效经济选择。【此简介由AI生成】Python00

MiniMax-M2.5MiniMax-M2.5开源模型,经数十万复杂环境强化训练,在代码生成、工具调用、办公自动化等经济价值任务中表现卓越。SWE-Bench Verified得分80.2%,Multi-SWE-Bench达51.3%,BrowseComp获76.3%。推理速度比M2.1快37%,与Claude Opus 4.6相当,每小时仅需0.3-1美元,成本仅为同类模型1/10-1/20,为智能应用开发提供高效经济选择。【此简介由AI生成】Python00 Qwen3.5Qwen3.5 昇腾 vLLM 部署教程。Qwen3.5 是 Qwen 系列最新的旗舰多模态模型,采用 MoE(混合专家)架构,在保持强大模型能力的同时显著降低了推理成本。00

Qwen3.5Qwen3.5 昇腾 vLLM 部署教程。Qwen3.5 是 Qwen 系列最新的旗舰多模态模型,采用 MoE(混合专家)架构,在保持强大模型能力的同时显著降低了推理成本。00- RRing-2.5-1TRing-2.5-1T:全球首个基于混合线性注意力架构的开源万亿参数思考模型。Python00