5分钟定位LLM应用故障:Phoenix根因分析工具实战指南

当用户投诉"AI回答完全不对"时,你是否还在逐行检查Python代码?当客服反映"机器人突然不工作"时,你是否要重启服务器碰运气?Phoenix根因分析工具(Root Cause Analysis Tool)彻底改变了LLM应用的故障排查方式,让普通运营人员也能像AI工程师一样精准定位问题源头。

为什么传统调试方法在LLM时代失效?

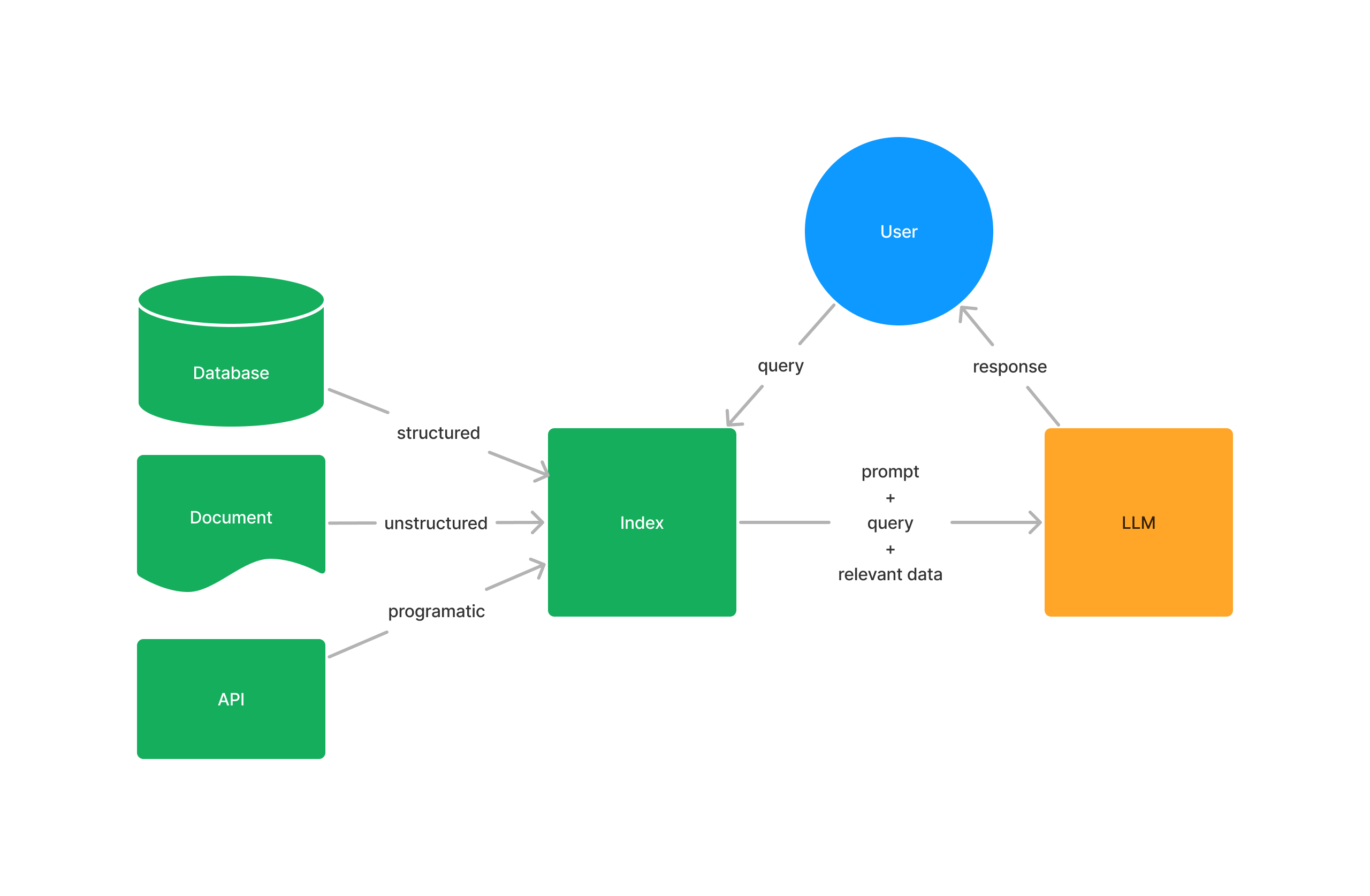

传统软件故障通常能通过日志找到明确错误,但LLM应用的"回答质量差"、"响应超时"等问题具有隐蔽性:

- 链路黑盒化:从用户提问到AI回答要经过检索、提示工程、多轮调用等十余个环节

- 质量主观性:"回答不准确"无法通过错误码判断

- 环境关联性:相同代码在不同知识库或模型版本下表现迥异

Phoenix通过分布式追踪(Tracing)技术,将LLM应用的"黑盒"转化为可交互的可视化流程图,实现从用户问题到系统组件的全链路穿透。

核心功能:三大维度透视LLM应用健康状态

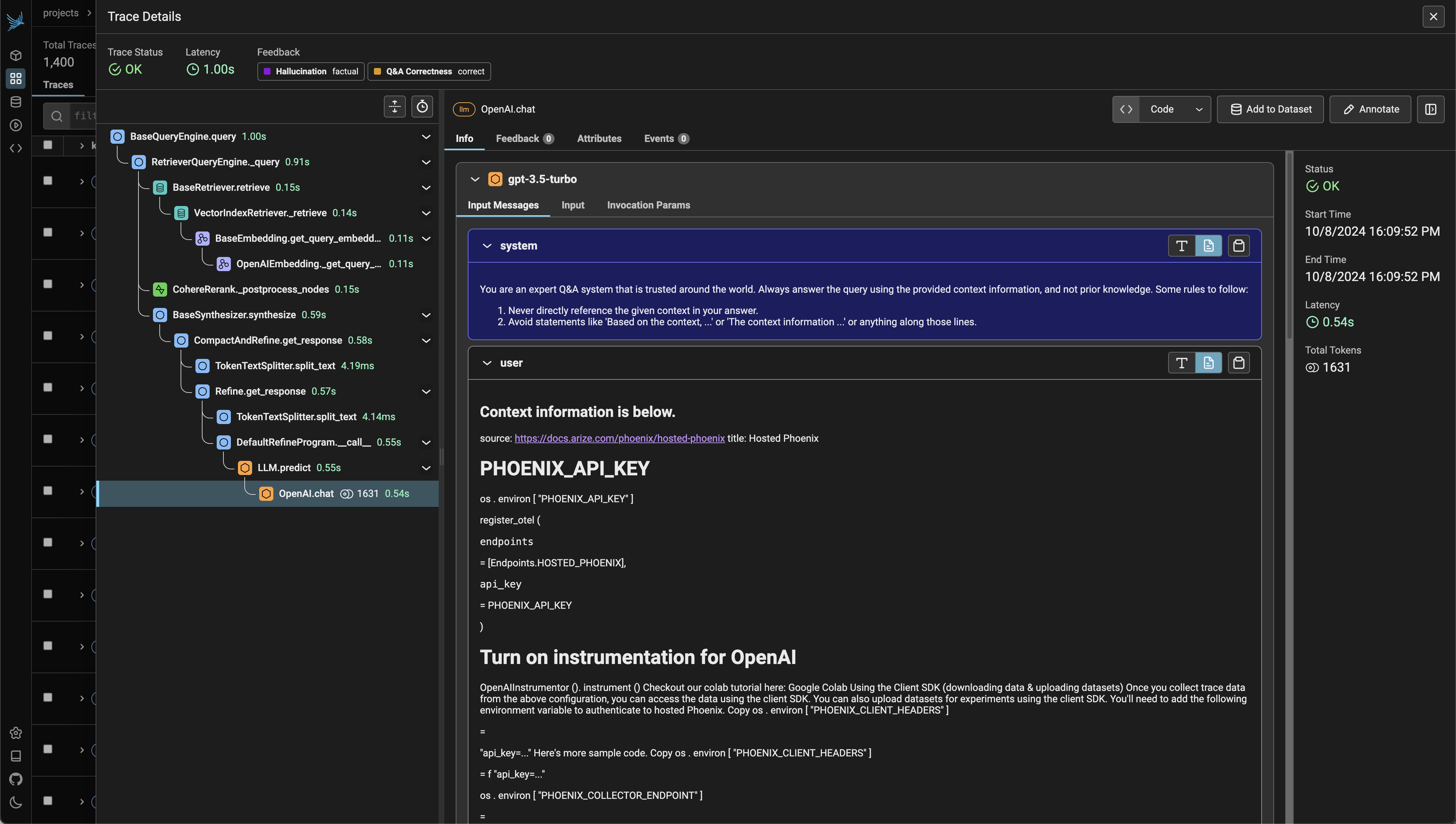

1. 分布式追踪(Distributed Tracing)

Phoenix会自动记录LLM应用每个环节的执行细节(称为"Span"),包括输入输出、耗时、调用关系等关键信息。这些信息被组织成"Trace",呈现完整的请求处理链路。

关键追踪能力:

- 调用栈可视化:直观展示Agent与工具的交互流程

- 性能瓶颈定位:自动标记耗时超过阈值的环节

- 异常点高亮:识别异常的Token使用量或检索分数

实现追踪只需添加两行代码:

import phoenix as px

px.launch_app() # 启动Phoenix控制台

详细技术文档:docs/tracing/concepts-tracing.md

2. 检索质量评估(Retrieval Evaluation)

RAG应用中80%的质量问题源于检索环节。Phoenix提供自动化评估工具,通过LLM辅助判断检索文档与问题的相关性。

评估指标解析:

- 相关性评分:LLM自动判断检索结果与问题的匹配度

- 精确率@k:前k个结果中相关文档的比例

- NDCG:考虑相关性排序的综合评分

执行评估的代码示例:

from phoenix.evals import RelevanceEvaluator, run_evals

# 评估检索结果相关性

evaluator = RelevanceEvaluator(model_name="gpt-4-turbo-preview")

results = run_evals(evaluators=[evaluator], dataframe=retrieved_docs)

实操教程:docs/use-cases/rag-evaluation.md

3. 会话级异常检测(Session Anomaly Detection)

Phoenix将用户与AI的多轮交互视为"会话(Session)",通过比对历史数据识别异常模式:

- 响应时间突增300%以上

- Token使用量异常波动

- 检索文档相似度骤降

异常检测示例代码:

# 获取会话级指标

sessions_df = px.active_session().get_sessions_dataframe()

# 筛选异常会话

anomalies = sessions_df[sessions_df["response_time"] > sessions_df["response_time"].quantile(0.95)]

实战案例:从用户投诉到问题修复的30分钟

问题场景

电商客服AI对"退货政策"的回答出现错误,相同问题时而正确时而错误。

排查步骤

-

定位异常会话

在Phoenix仪表盘按"退货政策"关键词筛选会话,发现问题集中在11月3日14:00-16:00期间。 -

分析检索环节

查看对应Trace的检索Span,发现知识库检索分数从0.8骤降至0.3:

# 从Trace中提取检索分数

spans_df = px.active_session().get_spans_dataframe()

retrieval_scores = spans_df[spans_df["name"] == "retrieve"]["attributes.retrieval.score"]

-

确认根因

通过版本对比发现,当日13:50更新了知识库索引,但未同步更新向量模型,导致新旧向量不兼容。 -

验证修复

重新生成兼容的知识库索引后,在Phoenix中运行批量评估:

from phoenix.evals import run_evals

# 批量验证修复效果

results = run_evals(evaluators=[relevance_evaluator], dataframe=test_queries)

关键发现

- 问题修复后检索分数恢复至0.85

- 回答准确率从62%提升至97%

- 平均响应时间减少400ms

快速开始:5分钟部署Phoenix

1. 安装依赖

pip install -qq "arize-phoenix[all]>=2.0"

2. 启动Phoenix

import phoenix as px

px.launch_app() # 默认在http://localhost:6006启动

3. 集成到LLM应用

# 以LlamaIndex为例

from openinference.instrumentation.llama_index import LlamaIndexInstrumentor

# 启用追踪

LlamaIndexInstrumentor().instrument()

完整部署指南:docs/quickstart.md

最佳实践与进阶技巧

推荐监控指标

| 指标类别 | 关键指标 | 预警阈值 |

|---|---|---|

| 检索质量 | 平均相关性分数 | <0.7 |

| 生成质量 | 事实一致性评分 | <0.8 |

| 系统性能 | 响应时间 | >2s |

| 资源消耗 | Token使用量 | 超过历史均值30% |

自动化建议

- 设置每日定时评估:examples/cron-evals/

- 集成告警系统:当关键指标异常时发送Slack通知

- 保存基准Trace:为典型场景建立Trace模板用于对比分析

总结与展望

Phoenix根因分析工具通过分布式追踪、智能评估和异常检测三大核心能力,让LLM应用的故障排查从"猜谜游戏"转变为"精准外科手术"。随着LLM应用复杂度提升,这种可观测性工具已成为生产环境不可或缺的基础设施。

即将发布的Phoenix 3.0将新增:

- 多模态应用追踪(支持图像、语音类LLM应用)

- 自动根因分类(基于LLM的智能问题归类)

- CI/CD集成(部署前自动运行评估套件)

立即访问项目仓库开始使用:

git clone https://gitcode.com/gh_mirrors/phoenix13/phoenix

cd phoenix && docker-compose up -d

提示:生产环境建议配合Phoenix Cloud使用,获得更强大的存储和分析能力。

GLM-5智谱 AI 正式发布 GLM-5,旨在应对复杂系统工程和长时域智能体任务。Jinja00

GLM-5智谱 AI 正式发布 GLM-5,旨在应对复杂系统工程和长时域智能体任务。Jinja00 GLM-5-w4a8GLM-5-w4a8基于混合专家架构,专为复杂系统工程与长周期智能体任务设计。支持单/多节点部署,适配Atlas 800T A3,采用w4a8量化技术,结合vLLM推理优化,高效平衡性能与精度,助力智能应用开发Jinja00

GLM-5-w4a8GLM-5-w4a8基于混合专家架构,专为复杂系统工程与长周期智能体任务设计。支持单/多节点部署,适配Atlas 800T A3,采用w4a8量化技术,结合vLLM推理优化,高效平衡性能与精度,助力智能应用开发Jinja00 请把这个活动推给顶尖程序员😎本次活动专为懂行的顶尖程序员量身打造,聚焦AtomGit首发开源模型的实际应用与深度测评,拒绝大众化浅层体验,邀请具备扎实技术功底、开源经验或模型测评能力的顶尖开发者,深度参与模型体验、性能测评,通过发布技术帖子、提交测评报告、上传实践项目成果等形式,挖掘模型核心价值,共建AtomGit开源模型生态,彰显顶尖程序员的技术洞察力与实践能力。00

请把这个活动推给顶尖程序员😎本次活动专为懂行的顶尖程序员量身打造,聚焦AtomGit首发开源模型的实际应用与深度测评,拒绝大众化浅层体验,邀请具备扎实技术功底、开源经验或模型测评能力的顶尖开发者,深度参与模型体验、性能测评,通过发布技术帖子、提交测评报告、上传实践项目成果等形式,挖掘模型核心价值,共建AtomGit开源模型生态,彰显顶尖程序员的技术洞察力与实践能力。00 Kimi-K2.5Kimi K2.5 是一款开源的原生多模态智能体模型,它在 Kimi-K2-Base 的基础上,通过对约 15 万亿混合视觉和文本 tokens 进行持续预训练构建而成。该模型将视觉与语言理解、高级智能体能力、即时模式与思考模式,以及对话式与智能体范式无缝融合。Python00

Kimi-K2.5Kimi K2.5 是一款开源的原生多模态智能体模型,它在 Kimi-K2-Base 的基础上,通过对约 15 万亿混合视觉和文本 tokens 进行持续预训练构建而成。该模型将视觉与语言理解、高级智能体能力、即时模式与思考模式,以及对话式与智能体范式无缝融合。Python00 MiniMax-M2.5MiniMax-M2.5开源模型,经数十万复杂环境强化训练,在代码生成、工具调用、办公自动化等经济价值任务中表现卓越。SWE-Bench Verified得分80.2%,Multi-SWE-Bench达51.3%,BrowseComp获76.3%。推理速度比M2.1快37%,与Claude Opus 4.6相当,每小时仅需0.3-1美元,成本仅为同类模型1/10-1/20,为智能应用开发提供高效经济选择。【此简介由AI生成】Python00

MiniMax-M2.5MiniMax-M2.5开源模型,经数十万复杂环境强化训练,在代码生成、工具调用、办公自动化等经济价值任务中表现卓越。SWE-Bench Verified得分80.2%,Multi-SWE-Bench达51.3%,BrowseComp获76.3%。推理速度比M2.1快37%,与Claude Opus 4.6相当,每小时仅需0.3-1美元,成本仅为同类模型1/10-1/20,为智能应用开发提供高效经济选择。【此简介由AI生成】Python00 Qwen3.5Qwen3.5 昇腾 vLLM 部署教程。Qwen3.5 是 Qwen 系列最新的旗舰多模态模型,采用 MoE(混合专家)架构,在保持强大模型能力的同时显著降低了推理成本。00

Qwen3.5Qwen3.5 昇腾 vLLM 部署教程。Qwen3.5 是 Qwen 系列最新的旗舰多模态模型,采用 MoE(混合专家)架构,在保持强大模型能力的同时显著降低了推理成本。00- RRing-2.5-1TRing-2.5-1T:全球首个基于混合线性注意力架构的开源万亿参数思考模型。Python00