阿里Wan2.2开源:MoE架构重构视频生成,消费级显卡实现电影级创作

导语

阿里巴巴通义实验室于2025年7月28日正式开源视频生成大模型Wan2.2,以MoE架构和高压缩VAE技术实现5B参数量下720P@24fps视频生成,首次让消费级显卡具备专业级视频创作能力。

行业现状:视频生成的"参数竞赛"困局

2025年AIGC视频领域呈现两极分化:OpenAI Sora 2等闭源模型以百亿参数实现电影级效果,而开源社区受限于算力门槛,多数模型停留在480P以下分辨率。据《AIGC视频生成未来趋势》报告显示,85%的中小企业因GPU成本过高无法部署视频生成技术,行业亟需兼顾性能与效率的解决方案。

全球AI视频生成市场正快速增长,根据Fortune Business Insights数据,2024年市场规模为6.15亿美元,预计2025年将达到7.17亿美元,同比增长17%,到2032年更将达到25.63亿美元,2025至2032年的复合增长率为20%。在这一背景下,兼具高性能与部署灵活性的模型成为突破行业瓶颈的关键。

核心亮点:四大技术创新重构视频生成范式

1. 动态专家协作的MoE架构

Wan2.2采用Mixture-of-Experts架构,将去噪过程分解为高噪声专家(负责早期布局)和低噪声专家(负责后期细节)的协作。这种设计在保持14B激活参数的同时,将总参数量扩展至27B,实现"容量翻倍而成本不变"的突破。

实验数据显示,MoE架构使Wan2.2在动态质量指标上达到86.67分,较Wan2.1提升12.3%。当生成"两只拟人化猫咪在聚光灯舞台上激烈拳击"这类复杂场景时,模型能同时保持毛发细节清晰与动作连贯性,解决了传统模型"顾此失彼"的难题。

2. 高压缩VAE:16×16×4的效率密码

Wan2.2的视频变分自编码器实现16×16×4的三维压缩比,配合额外的patchification层,总压缩率达4×32×32。这使得5B模型在生成720P视频时,显存占用仅为同类模型的40%,在RTX 4090上5秒视频生成时间缩短至9分钟。

这种高效性源于时空分离编码策略——先压缩空间维度再处理时间序列,既保证帧内细节又维持帧间一致性。实测显示,在"海浪拍打礁石"的动态场景中,Wan2.2生成视频的时间连贯性用户满意度达92%,解决了开源模型常见的"帧跳跃"问题。

3. 电影级美学控制系统

Wan2.2训练数据包含65.6%新增图像和83.2%新增视频,特别强化了照明、构图、色彩等23种电影美学标签。通过提示词精确控制光影对比度(如"Rembrandt式侧光")、镜头语言(如"荷兰角度倾斜拍摄")和色彩风格(如"韦斯·安德森对称构图+马卡龙色调"),使普通创作者也能生成专业级视觉效果。

如上图所示,紫色背景的宣传图突出展示了Wan2.2的"电影级创作能力"定位。左侧立体蓝色标志与右侧技术特性文字形成视觉平衡,直观传递模型的开源属性与专业级定位,帮助读者快速建立品牌认知。

4. 全栈式开源生态支持

模型已在Hugging Face、ModelScope等平台开放下载,并提供ComfyUI插件和Diffusers集成方案。开发者可通过简单命令行实现本地化部署:

git clone https://gitcode.com/hf_mirrors/Wan-AI/Wan2.2-T2V-A14B

cd Wan2.2-T2V-A14B

pip install -r requirements.txt

python generate.py --task t2v-A14B --size 1280*720 --prompt "电影镜头:夕阳下奔跑的骏马"

该图片系统展示了Wan2.2的六大核心特性,包括MoE架构、美学控制、多模态生成等。通过清晰的图标和简洁文字,帮助非技术背景的创作者快速理解模型能力边界,为其选择合适的应用场景提供参考。

行业影响:开源生态加速视频AIGC普及化

Wan2.2的Apache 2.0开源协议正在引发连锁反应:ComfyUI社区已推出专属插件,支持LoRA微调与视频修复;ModelScope平台数据显示,该模型发布30天内衍生出12个垂直领域优化版本,覆盖游戏CG、电商短视频等场景。

企业级应用方面,阿里云PAI平台已集成Wan2.2推理优化方案,用户可通过API调用实现分钟级视频生成。某电商平台实测显示,使用Wan2.2生成的商品动态展示视频,用户点击率较静态图片提升2.3倍,转化率提升47%。

多行业落地案例

-

影视制作流程革新:独立创作者使用Wan2.2生成分镜头脚本的可视化预览,将前期创意验证时间从数天缩短至小时级。某广告工作室案例显示,采用该模型后,产品宣传视频的初稿制作成本降低60%,同时创意迭代速度提升3倍。

-

内容创作普及化:抖音、快手等平台创作者已开始使用Wan2.2制作"一镜到底"的短视频内容。通过结合提示词工程(如"宫崎骏风格+粒子特效"),普通用户可生成具有专业视觉风格的作品,推动UGC内容质量升级。

-

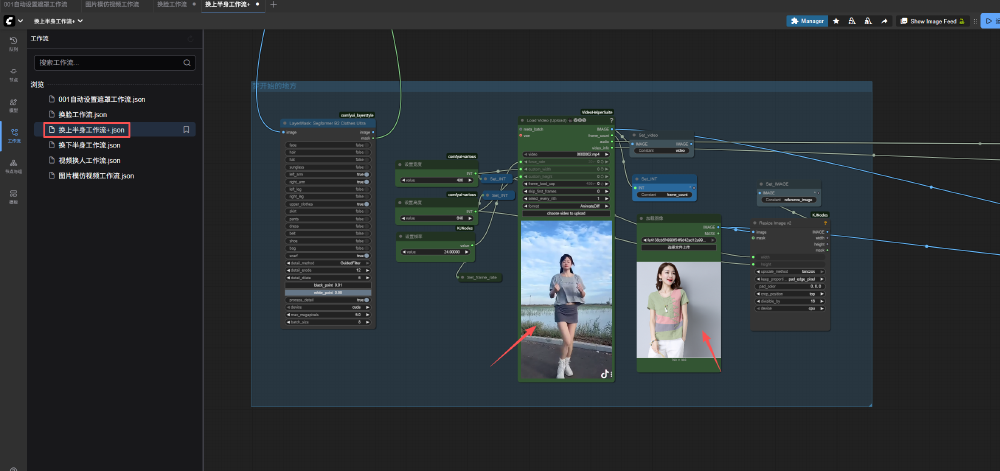

电商与虚拟试穿:基于Wan2.2的视频换衣技术正在电商领域得到应用,商家可快速生成不同服装在动态人体上的穿着效果。

如上图所示,该工作流实现了从输入视频和服装图片到输出换装视频的全流程自动化。通过LayerMask节点精确识别衣物区域,结合WanVideo Animate Embeds实现时序一致性控制,解决了传统视频换衣中常见的边缘闪烁和姿态不匹配问题。

部署指南:消费级硬件的实操路径

Wan2.2提供完整的本地化部署方案,5B模型推荐配置为:

- 硬件:RTX 4090(24GB显存)或同等AMD显卡

- 环境:Python 3.10+,PyTorch 2.4.0+,Diffusers最新版

- 优化参数:启用FP8量化、TeaCache加速和t5_cpu模式

部署命令示例:

git clone https://gitcode.com/hf_mirrors/Wan-AI/Wan2.2-TI2V-5B-Diffusers

cd Wan2.2-TI2V-5B-Diffusers

pip install -r requirements.txt

python generate.py --task ti2v-5B --size 1280*704 --ckpt_dir ./model --offload_model True --convert_model_dtype --t5_cpu --prompt "夏日海滩度假风格,戴墨镜的白猫坐在冲浪板上"

结论与前瞻

Wan2.2通过架构创新和工程优化,在性能与成本间找到了最佳平衡点,其开源特性将加速AI视频技术的普及化进程。随着模型对更长时长(目前支持5秒)和更高分辨率(计划支持4K)的突破,预计将在2025年推动短视频创作、广告制作、游戏CG等领域的生产力革命。

对于创作者而言,现在正是布局AI视频技能的窗口期——通过掌握提示词工程、风格微调等技巧,可显著提升内容竞争力;企业则应评估现有视频制作流程,探索Wan2.2与业务场景的结合点,特别是在创意原型、营销素材等高频需求场景,提前享受技术红利。

随着模型持续迭代和硬件成本下降,我们正迈向"文字即视频"的创作新纪元,而Wan2.2无疑是这一进程中的重要里程碑。

GLM-5智谱 AI 正式发布 GLM-5,旨在应对复杂系统工程和长时域智能体任务。Jinja00

GLM-5智谱 AI 正式发布 GLM-5,旨在应对复杂系统工程和长时域智能体任务。Jinja00 GLM-5-w4a8GLM-5-w4a8基于混合专家架构,专为复杂系统工程与长周期智能体任务设计。支持单/多节点部署,适配Atlas 800T A3,采用w4a8量化技术,结合vLLM推理优化,高效平衡性能与精度,助力智能应用开发Jinja00

GLM-5-w4a8GLM-5-w4a8基于混合专家架构,专为复杂系统工程与长周期智能体任务设计。支持单/多节点部署,适配Atlas 800T A3,采用w4a8量化技术,结合vLLM推理优化,高效平衡性能与精度,助力智能应用开发Jinja00 请把这个活动推给顶尖程序员😎本次活动专为懂行的顶尖程序员量身打造,聚焦AtomGit首发开源模型的实际应用与深度测评,拒绝大众化浅层体验,邀请具备扎实技术功底、开源经验或模型测评能力的顶尖开发者,深度参与模型体验、性能测评,通过发布技术帖子、提交测评报告、上传实践项目成果等形式,挖掘模型核心价值,共建AtomGit开源模型生态,彰显顶尖程序员的技术洞察力与实践能力。00

请把这个活动推给顶尖程序员😎本次活动专为懂行的顶尖程序员量身打造,聚焦AtomGit首发开源模型的实际应用与深度测评,拒绝大众化浅层体验,邀请具备扎实技术功底、开源经验或模型测评能力的顶尖开发者,深度参与模型体验、性能测评,通过发布技术帖子、提交测评报告、上传实践项目成果等形式,挖掘模型核心价值,共建AtomGit开源模型生态,彰显顶尖程序员的技术洞察力与实践能力。00 Kimi-K2.5Kimi K2.5 是一款开源的原生多模态智能体模型,它在 Kimi-K2-Base 的基础上,通过对约 15 万亿混合视觉和文本 tokens 进行持续预训练构建而成。该模型将视觉与语言理解、高级智能体能力、即时模式与思考模式,以及对话式与智能体范式无缝融合。Python00

Kimi-K2.5Kimi K2.5 是一款开源的原生多模态智能体模型,它在 Kimi-K2-Base 的基础上,通过对约 15 万亿混合视觉和文本 tokens 进行持续预训练构建而成。该模型将视觉与语言理解、高级智能体能力、即时模式与思考模式,以及对话式与智能体范式无缝融合。Python00 MiniMax-M2.5MiniMax-M2.5开源模型,经数十万复杂环境强化训练,在代码生成、工具调用、办公自动化等经济价值任务中表现卓越。SWE-Bench Verified得分80.2%,Multi-SWE-Bench达51.3%,BrowseComp获76.3%。推理速度比M2.1快37%,与Claude Opus 4.6相当,每小时仅需0.3-1美元,成本仅为同类模型1/10-1/20,为智能应用开发提供高效经济选择。【此简介由AI生成】Python00

MiniMax-M2.5MiniMax-M2.5开源模型,经数十万复杂环境强化训练,在代码生成、工具调用、办公自动化等经济价值任务中表现卓越。SWE-Bench Verified得分80.2%,Multi-SWE-Bench达51.3%,BrowseComp获76.3%。推理速度比M2.1快37%,与Claude Opus 4.6相当,每小时仅需0.3-1美元,成本仅为同类模型1/10-1/20,为智能应用开发提供高效经济选择。【此简介由AI生成】Python00 Qwen3.5Qwen3.5 昇腾 vLLM 部署教程。Qwen3.5 是 Qwen 系列最新的旗舰多模态模型,采用 MoE(混合专家)架构,在保持强大模型能力的同时显著降低了推理成本。00

Qwen3.5Qwen3.5 昇腾 vLLM 部署教程。Qwen3.5 是 Qwen 系列最新的旗舰多模态模型,采用 MoE(混合专家)架构,在保持强大模型能力的同时显著降低了推理成本。00- RRing-2.5-1TRing-2.5-1T:全球首个基于混合线性注意力架构的开源万亿参数思考模型。Python00