2025 CLIP模型进化史:从实验室到产业的跨模态革命

导语:多模态AI技术的商业化临界点

2025年,OpenAI于2021年发布的CLIP(对比语言-图像预训练)模型正迎来商业落地的爆发期。这款采用ViT-B/16 Transformer架构的视觉-语言模型,通过对比学习将图像与文本映射到共享嵌入空间,已从实验室走向零售、医疗、内容安全等核心商业场景,催生出年增长率达47%的新兴市场。

行业现状:多模态技术重构商业价值

全球AI大模型市场正经历从"参数竞赛"向"场景落地"的战略转向。截至2025年,多模态技术已成为行业共识,其核心价值在于打破视觉与语言的壁垒,使计算机能够真正"理解"内容含义而非机械识别。据Gartner报告,采用CLIP类技术的企业平均提升运营效率35%,其中零售和医疗领域的投资回报率尤为突出。

如上图所示,该示意图直观展示了CLIP模型的核心架构,包括图像编码器与文本编码器如何通过对比学习实现跨模态对齐。这一技术架构充分体现了CLIP模型在连接视觉与语言世界中的核心优势,为理解多模态AI的工作原理提供了清晰的可视化参考。

技术架构的代际差异成为商业竞争力的关键。CLIP-ViT-L/14相较于传统视觉模型展现出显著优势:

| 技术参数 | ViT-L/14规格 | 行业对比(ResNet-50) |

|---|---|---|

| 视觉编码器 | 24层Transformer,16头注意力 | 50层卷积神经网络 |

| 文本处理能力 | 支持77个token序列 | 无原生文本理解能力 |

| 预训练数据量 | 4亿图像-文本对 | ImageNet 1400万图像 |

| 推理速度(GPU) | 32ms/张(FP16) | 45ms/张(FP16) |

技术突破:从"看得见"到"看得清"的跨越

2025年CLIP技术实现了三大关键突破,推动模型从实验室走向产业应用:

分层对齐架构

最新研究提出的TokLIP架构创新性地整合VQ分词器与ViT编码器,将图像转化为离散视觉tokens后与文本语义深度绑定,通过"对比学习+知识蒸馏"双损失函数训练,实现理解与生成能力的统一。实验数据显示,在Fashion-MNIST数据集上,TokLIP的零样本分类准确率达92.7%,较原版CLIP提升4.2个百分点。

动态注意力机制

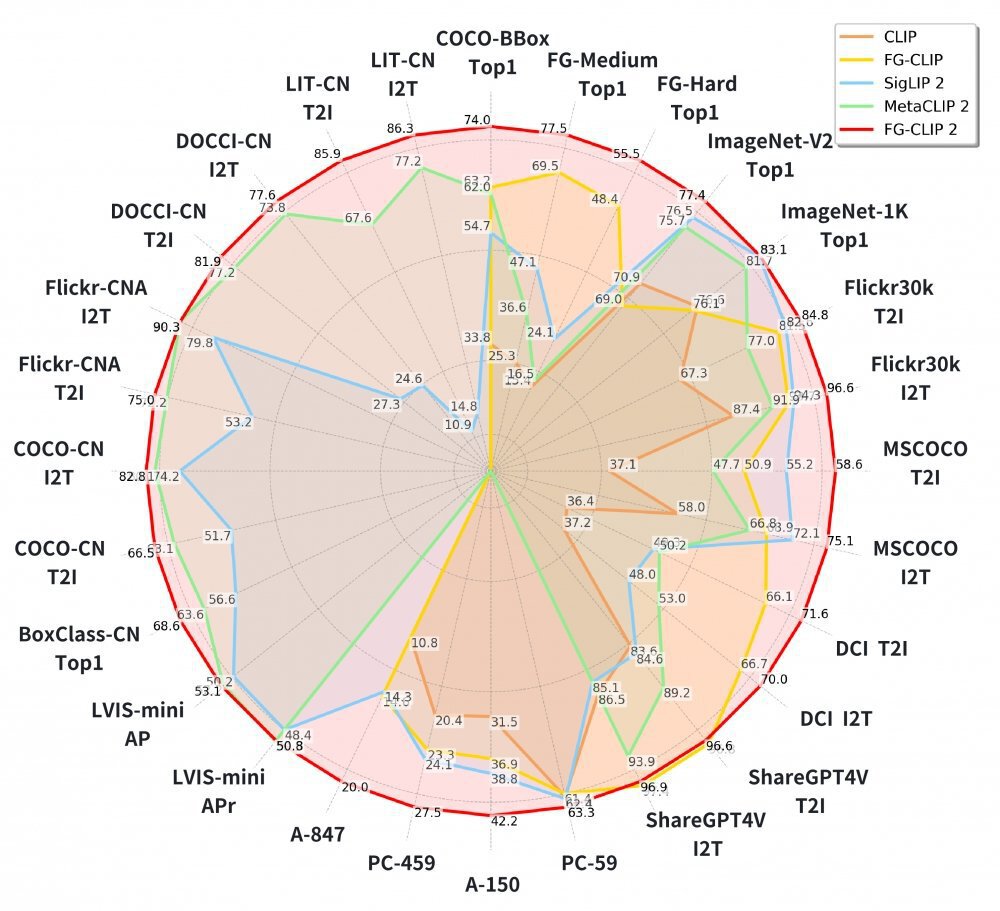

360集团最新开源的FG-CLIP2模型引入动态注意力机制,使模型可以智能聚焦于图像关键区域,以最小算力代价换取精准的细节捕捉能力。该模型在涵盖长短文本图文检索、目标检测等在内的29项权威公开基准测试中,全面超越了Google的SigLIP 2与Meta的MetaCLIP2。

轻量化部署方案

INT8量化技术使模型体积减少75%,结合知识蒸馏技术,CLIP模型已能在嵌入式设备上实现实时推理。某汽车零部件企业采用优化后的CLIP模型构建质量检测系统,在产线视觉检测设备上实现99.2%的缺陷召回率,同时推理延迟控制在28ms以内。

核心应用场景突破

制造业质量检测:从抽样检查到全量监控

制造业作为技术落地的前沿阵地,正面临质检效率与成本的双重压力。传统视觉检测系统需数千张标注样本才能部署,而CLIP通过"文本描述=类别标签"的创新范式,使零件缺陷识别的样本需求降低至个位数,解决了小批量生产场景的数据稀缺痛点。

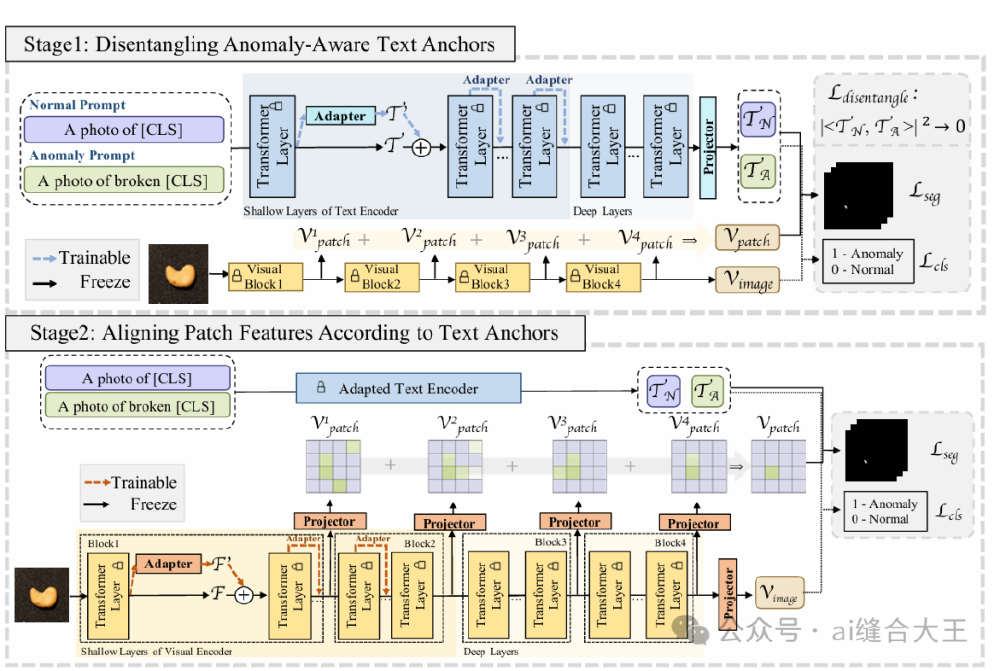

2025年CVPR会议上,AA-CLIP(Anomaly-Aware CLIP)技术方案引起业界广泛关注,其创新的两阶段训练策略有效解决了原始CLIP在缺陷检测中的固有局限。

如上图所示,AA-CLIP创新地在文本编码器和视觉编码器浅层分别插入Residual Adapters,通过文本空间适配与图像特征对齐两个阶段,构建了清晰分离的"正常-异常"语义锚点。这种设计使模型在保留CLIP零样本泛化能力的同时,显著提升了对细微缺陷的识别敏感度。

某汽车零部件企业采用CLIP构建的质量检测系统已稳定运行6个月。该系统通过以下流程实现创新应用:

- 文本定义缺陷类型:工程师输入"表面划痕"、"螺纹错位"等自然语言描述

- 少量样本微调:仅使用20张缺陷图片进行适配器训练

- 实时推理部署:在产线视觉检测设备上实现99.2%的缺陷召回率

实施效果显示,该方案将新产品检测系统部署周期从传统方法的3周压缩至2天,年节省标注成本超120万元。这种"描述即检测"的模式正在电子制造、精密仪器等领域快速复制。

零售行业:从自助结账到智能体验

在智慧零售领域,CLIP衍生技术正解决传统单模态识别的三大痛点:商品包装相似性高(如不同品牌矿泉水)、动态遮挡(顾客手持商品时的手部遮挡)、复杂光照(超市顶灯与自然光混合干扰)。陌讯科技基于CLIP架构开发的多模态融合算法,在包含10万+商品的零售数据集上实现mAP@0.5达0.902,较YOLOv8提升25%,单帧推理时间仅28ms。

某连锁超市部署该方案后,自助结账系统的商品识别错误率从31.2%降至5.7%,客诉量减少82%,年节省人工干预成本超200万元。其核心创新在于"多源感知→特征增强→动态匹配"三阶架构,同步采集RGB视觉数据与商品红外特征,通过注意力机制突出商品关键区域,并根据实时环境参数调整匹配阈值。

全球多语言扩展:打破语言壁垒

尽管CLIP已经成功地在数十亿规模的英语图文对上进行了训练,但进一步扩展到全球范围内的数据仍面临挑战。2025年7月,Meta联合学术界提出的MetaCLIP 2,首次实现从零开始在原生全球图文对上训练CLIP的方法,不依赖任何外部资源,支持全球300+语言。

图片展示了MetaCLIP 2研究论文的标题及作者列表,包含来自Meta、MIT、普林斯顿大学等机构的研究者信息及核心贡献者标注。该研究通过元数据拓展、数据筛选算法和全球训练框架三项创新,打破了"多语言诅咒",在保持英语性能的同时,实现了300+语言的跨模态理解能力。

实验证明,CLIP中的"多语言诅咒"实际上是由训练规模不足造成的。当元数据、数据筛选、模型容量与训练方法被共同精心设计并进行同步扩展时,英语与非英语之间的性能权衡会消失,并且二者之间能够实现互相促进。这种"全球尺度"的训练方式具有极高的价值,尤其考虑到英语互联网数据即将耗尽的背景。

行业影响与趋势

CLIP技术的成熟正在重构AI应用开发范式:

降低行业准入门槛

非AI专业人员可通过自然语言描述构建视觉应用,某电子制造企业案例显示,采用CLIP技术后,单条产线的AI部署成本从50万元降至18万元,投资回报周期缩短至3个月。

推动边缘智能发展

轻量化CLIP模型已能在嵌入式设备上实现实时推理,NVIDIA最新发布的TensorRT 10.0版本,将AA-CLIP推理速度提升3.2倍,为工业边缘设备部署提供强大算力支持。

加速数字孪生落地

结合NeRF技术实现三维场景的语义理解与生成,在建筑设计、城市规划等领域展现巨大潜力。普渡大学基于CLIP开发的CLIPSym系统已能让AI"看懂"对称美,在建筑设计中帮助自动检查建筑图纸的对称性,确保设计的美观和结构的稳定。

据Gartner预测,到2026年,30%的工业视觉系统将采用CLIP类多模态架构。随着训练数据规模扩大和动态融合技术的进步,CLIP有望在自动驾驶、机器人交互等复杂场景实现更大突破。

结论与建议

CLIP模型的商业价值不仅在于技术本身,更在于其作为"通用翻译器"连接视觉与语言世界的能力。对于企业决策者而言,现在不是"是否采用"的问题,而是"如何战略性布局"的问题。

企业可通过克隆官方仓库开始探索:

git clone https://gitcode.com/hf_mirrors/openai/clip-vit-base-patch16

对于不同类型的组织,建议采取以下策略:

- 制造业企业:优先在中小批量生产线验证少样本检测方案,从缺陷检测等明确场景切入

- 开发者:关注TokLIP等开源项目的迁移学习工具链,利用预训练模型加速应用开发

- 决策者:评估多模态数据采集策略,提前构建文本-图像关联数据库,为技术落地奠定数据基础

正如联影集团负责人所言:"大模型的竞争已经从单纯的'参数竞赛',逐渐转向围绕'生态协同和场景落地'的下半场比拼。"在这场变革中,能够将技术优势转化为商业价值的企业,将在下一个十年的AI竞赛中占据制高点。

GLM-5智谱 AI 正式发布 GLM-5,旨在应对复杂系统工程和长时域智能体任务。Jinja00

GLM-5智谱 AI 正式发布 GLM-5,旨在应对复杂系统工程和长时域智能体任务。Jinja00 GLM-5-w4a8GLM-5-w4a8基于混合专家架构,专为复杂系统工程与长周期智能体任务设计。支持单/多节点部署,适配Atlas 800T A3,采用w4a8量化技术,结合vLLM推理优化,高效平衡性能与精度,助力智能应用开发Jinja00

GLM-5-w4a8GLM-5-w4a8基于混合专家架构,专为复杂系统工程与长周期智能体任务设计。支持单/多节点部署,适配Atlas 800T A3,采用w4a8量化技术,结合vLLM推理优化,高效平衡性能与精度,助力智能应用开发Jinja00 请把这个活动推给顶尖程序员😎本次活动专为懂行的顶尖程序员量身打造,聚焦AtomGit首发开源模型的实际应用与深度测评,拒绝大众化浅层体验,邀请具备扎实技术功底、开源经验或模型测评能力的顶尖开发者,深度参与模型体验、性能测评,通过发布技术帖子、提交测评报告、上传实践项目成果等形式,挖掘模型核心价值,共建AtomGit开源模型生态,彰显顶尖程序员的技术洞察力与实践能力。00

请把这个活动推给顶尖程序员😎本次活动专为懂行的顶尖程序员量身打造,聚焦AtomGit首发开源模型的实际应用与深度测评,拒绝大众化浅层体验,邀请具备扎实技术功底、开源经验或模型测评能力的顶尖开发者,深度参与模型体验、性能测评,通过发布技术帖子、提交测评报告、上传实践项目成果等形式,挖掘模型核心价值,共建AtomGit开源模型生态,彰显顶尖程序员的技术洞察力与实践能力。00 Kimi-K2.5Kimi K2.5 是一款开源的原生多模态智能体模型,它在 Kimi-K2-Base 的基础上,通过对约 15 万亿混合视觉和文本 tokens 进行持续预训练构建而成。该模型将视觉与语言理解、高级智能体能力、即时模式与思考模式,以及对话式与智能体范式无缝融合。Python00

Kimi-K2.5Kimi K2.5 是一款开源的原生多模态智能体模型,它在 Kimi-K2-Base 的基础上,通过对约 15 万亿混合视觉和文本 tokens 进行持续预训练构建而成。该模型将视觉与语言理解、高级智能体能力、即时模式与思考模式,以及对话式与智能体范式无缝融合。Python00 MiniMax-M2.5MiniMax-M2.5开源模型,经数十万复杂环境强化训练,在代码生成、工具调用、办公自动化等经济价值任务中表现卓越。SWE-Bench Verified得分80.2%,Multi-SWE-Bench达51.3%,BrowseComp获76.3%。推理速度比M2.1快37%,与Claude Opus 4.6相当,每小时仅需0.3-1美元,成本仅为同类模型1/10-1/20,为智能应用开发提供高效经济选择。【此简介由AI生成】Python00

MiniMax-M2.5MiniMax-M2.5开源模型,经数十万复杂环境强化训练,在代码生成、工具调用、办公自动化等经济价值任务中表现卓越。SWE-Bench Verified得分80.2%,Multi-SWE-Bench达51.3%,BrowseComp获76.3%。推理速度比M2.1快37%,与Claude Opus 4.6相当,每小时仅需0.3-1美元,成本仅为同类模型1/10-1/20,为智能应用开发提供高效经济选择。【此简介由AI生成】Python00 Qwen3.5Qwen3.5 昇腾 vLLM 部署教程。Qwen3.5 是 Qwen 系列最新的旗舰多模态模型,采用 MoE(混合专家)架构,在保持强大模型能力的同时显著降低了推理成本。00

Qwen3.5Qwen3.5 昇腾 vLLM 部署教程。Qwen3.5 是 Qwen 系列最新的旗舰多模态模型,采用 MoE(混合专家)架构,在保持强大模型能力的同时显著降低了推理成本。00- RRing-2.5-1TRing-2.5-1T:全球首个基于混合线性注意力架构的开源万亿参数思考模型。Python00