20分钟上手!WeChat Bot贡献代码完全指南:从环境搭建到PR提交

你是否曾想为开源项目贡献代码,却被复杂的流程吓退?本文将带你20分钟内掌握WeChat Bot项目的贡献全流程,从环境配置到代码提交,让你的开源贡献之旅零门槛起步。读完本文,你将能够:

- 快速搭建本地开发环境

- 理解项目核心模块架构

- 开发新功能或修复bug

- 提交高质量PR并通过审核

项目架构速览

WeChat Bot是一个基于WeChaty框架开发的微信机器人,集成了多种AI服务实现智能回复功能。项目采用模块化设计,主要分为以下几个核心部分:

核心目录结构

GitHub_Trending/we/wechat-bot/

├── src/ # 源代码目录

│ ├── wechaty/ # WeChaty核心模块

│ │ ├── sendMessage.js # 消息发送逻辑

│ │ ├── serve.js # AI服务路由

│ │ └── testMessage.js # 消息测试

│ ├── [ai-service]/ # 各AI服务实现

│ │ ├── index.js # 服务入口

│ │ └── __test__.js # 单元测试

│ └── index.js # 项目入口

├── package.json # 项目依赖配置

└── .env.example # 环境变量示例

关键模块解析

- 消息处理模块:src/wechaty/sendMessage.js 负责消息接收和回复逻辑,包含群聊和私聊处理

- AI服务路由:src/wechaty/serve.js 管理不同AI服务的路由分发,目前支持12种AI服务

- AI服务实现:每个AI服务对应独立目录,如src/openai/、src/kimi/等,遵循统一接口规范

开发环境搭建

准备工作

在开始之前,请确保你的开发环境满足以下要求:

- Node.js >= v18.0(推荐LTS版本)

- Git

- npm或yarn

- 微信账号(用于测试)

步骤1:克隆代码库

git clone https://gitcode.com/GitHub_Trending/we/wechat-bot.git

cd wechat-bot

步骤2:安装依赖

# 使用npm

npm install

# 或使用yarn(推荐)

yarn install

中国大陆用户建议切换npm镜像源加速安装:

npm config set registry https://registry.npmmirror.com

步骤3:配置环境变量

复制环境变量示例文件并根据需要修改:

cp .env.example .env

编辑.env文件,至少配置一种AI服务的API密钥,例如OpenAI:

OPENAI_API_KEY=你的API密钥

OPENAI_MODEL=gpt-4o

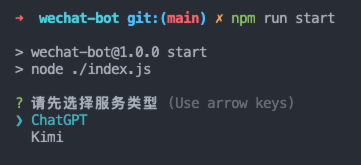

步骤4:验证安装

运行测试命令验证环境是否配置成功:

# 测试OpenAI服务

npm run test-openai

# 或测试Kimi服务

npm run test-kimi

如果一切正常,你将看到AI服务返回的测试回复。

开发新功能

功能开发流程

WeChat Bot采用"功能模块化"开发方式,新增功能或AI服务遵循以下流程:

graph TD

A[确定需求] --> B[创建模块目录]

B --> C[实现核心功能]

C --> D[编写单元测试]

D --> E[更新服务路由]

E --> F[本地测试验证]

示例:添加新的AI服务

下面以添加"NewAI"服务为例,演示完整开发流程:

- 创建模块目录

mkdir -p src/newai

touch src/newai/index.js src/newai/__test__.js

- 实现核心功能

import axios from 'axios'

import dotenv from 'dotenv'

const env = dotenv.config().parsed

export async function getNewAiReply(prompt) {

try {

const response = await axios.post(

env.NEWAI_API_URL,

{

prompt: prompt,

model: env.NEWAI_MODEL || 'default-model'

},

{

headers: {

'Content-Type': 'application/json',

'Authorization': `Bearer ${env.NEWAI_API_KEY}`

}

}

)

return response.data.choices[0].text

} catch (error) {

console.error('NewAI API error:', error)

throw error

}

}

- 编写单元测试

import { getNewAiReply } from './index.js'

async function testNewAI() {

try {

const response = await getNewAiReply('Hello, NewAI!')

console.log('NewAI 回复:', response)

} catch (error) {

console.error('测试失败:', error)

}

}

testNewAI()

- 更新服务路由

修改src/wechaty/serve.js,添加新服务路由:

import { getNewAiReply } from '../newai/index.js'

// ...

export function getServe(serviceType) {

switch (serviceType) {

// ... 现有服务

case 'newai':

return getNewAiReply

default:

return getGptReply

}

}

- 本地测试

# 添加测试命令到package.json

npm run start -- --serve newai

代码规范与提交

代码风格

项目使用Prettier进行代码格式化,提交前请确保代码风格一致:

# 自动格式化代码

npm run format

提交规范

提交代码时,请遵循以下格式:

<type>(<scope>): <subject>

<body>

<footer>

- type:提交类型(feat: 新功能, fix: 修复bug, docs: 文档更新等)

- scope:影响范围(如wechaty, openai, kimi等)

- subject:简短描述(不超过50字符)

示例:

feat(kimi): 添加长文本处理支持

- 实现Kimi 128k模型的流式响应

- 添加文本分片处理逻辑

Closes #123

提交PR流程

- 创建分支

git checkout -b feature/your-feature-name

- 提交更改

git add .

git commit -m "feat: 添加新功能描述"

- 推送到远程

git push origin feature/your-feature-name

- 创建PR

访问项目GitCode页面,点击"创建Pull Request",填写PR描述并提交。

测试与调试

测试策略

为确保代码质量,所有贡献都应包含适当的测试:

- 单元测试:每个AI服务提供test.js测试文件

- 集成测试:通过src/wechaty/testMessage.js测试消息处理流程

- 手动测试:运行完整机器人进行实际场景测试

运行与调试

# 开发模式运行

npm run dev

# 指定AI服务运行

npm run start -- --serve Kimi

运行后,扫描终端显示的二维码登录微信,即可测试机器人功能。

常见问题解决

依赖安装问题

-

puppeteer安装失败:设置环境变量跳过下载

# Mac/Linux export PUPPETEER_SKIP_DOWNLOAD='true' # Windows SET PUPPETEER_SKIP_DOWNLOAD='true' -

Wechaty安装问题:确保Node.js版本符合要求,尝试删除node_modules后重新安装

API调用问题

-

连接超时:检查代理设置,确保终端可以访问API服务

# 设置终端代理 export https_proxy=http://127.0.0.1:你的代理端口 -

API密钥错误:验证.env文件中的API密钥是否正确,权限是否足够

微信登录问题

- 登录二维码不显示:检查终端是否支持ANSI转义序列

- 登录后无响应:确认微信账号未开启设备锁,或尝试使用备用微信账号

贡献者指南

PR审核标准

为确保项目质量,PR需要满足以下条件:

- 代码符合项目风格规范

- 包含适当的测试用例

- 不引入破坏性变更

- 文档(如需要)已更新

- 所有CI检查通过

社区交流

贡献者名单

感谢所有为项目做出贡献的开发者:

总结与展望

本文详细介绍了WeChat Bot项目的贡献流程,从环境搭建到PR提交的完整步骤。通过模块化的设计,项目使得添加新功能或集成新AI服务变得简单直观。

未来,项目计划进一步优化:

- 完善插件系统,支持动态加载

- 增强多语言支持

- 提供更丰富的机器人管理功能

如果你觉得本指南对你有帮助,请点赞、收藏并关注项目,以便获取最新更新。期待你的第一个PR,让我们一起让WeChat Bot变得更加强大!

下一篇预告:《深入理解WeChat Bot的消息处理机制》,敬请关注!

GLM-5智谱 AI 正式发布 GLM-5,旨在应对复杂系统工程和长时域智能体任务。Jinja00

GLM-5智谱 AI 正式发布 GLM-5,旨在应对复杂系统工程和长时域智能体任务。Jinja00 GLM-5-w4a8GLM-5-w4a8基于混合专家架构,专为复杂系统工程与长周期智能体任务设计。支持单/多节点部署,适配Atlas 800T A3,采用w4a8量化技术,结合vLLM推理优化,高效平衡性能与精度,助力智能应用开发Jinja00

GLM-5-w4a8GLM-5-w4a8基于混合专家架构,专为复杂系统工程与长周期智能体任务设计。支持单/多节点部署,适配Atlas 800T A3,采用w4a8量化技术,结合vLLM推理优化,高效平衡性能与精度,助力智能应用开发Jinja00 请把这个活动推给顶尖程序员😎本次活动专为懂行的顶尖程序员量身打造,聚焦AtomGit首发开源模型的实际应用与深度测评,拒绝大众化浅层体验,邀请具备扎实技术功底、开源经验或模型测评能力的顶尖开发者,深度参与模型体验、性能测评,通过发布技术帖子、提交测评报告、上传实践项目成果等形式,挖掘模型核心价值,共建AtomGit开源模型生态,彰显顶尖程序员的技术洞察力与实践能力。00

请把这个活动推给顶尖程序员😎本次活动专为懂行的顶尖程序员量身打造,聚焦AtomGit首发开源模型的实际应用与深度测评,拒绝大众化浅层体验,邀请具备扎实技术功底、开源经验或模型测评能力的顶尖开发者,深度参与模型体验、性能测评,通过发布技术帖子、提交测评报告、上传实践项目成果等形式,挖掘模型核心价值,共建AtomGit开源模型生态,彰显顶尖程序员的技术洞察力与实践能力。00 Kimi-K2.5Kimi K2.5 是一款开源的原生多模态智能体模型,它在 Kimi-K2-Base 的基础上,通过对约 15 万亿混合视觉和文本 tokens 进行持续预训练构建而成。该模型将视觉与语言理解、高级智能体能力、即时模式与思考模式,以及对话式与智能体范式无缝融合。Python00

Kimi-K2.5Kimi K2.5 是一款开源的原生多模态智能体模型,它在 Kimi-K2-Base 的基础上,通过对约 15 万亿混合视觉和文本 tokens 进行持续预训练构建而成。该模型将视觉与语言理解、高级智能体能力、即时模式与思考模式,以及对话式与智能体范式无缝融合。Python00 MiniMax-M2.5MiniMax-M2.5开源模型,经数十万复杂环境强化训练,在代码生成、工具调用、办公自动化等经济价值任务中表现卓越。SWE-Bench Verified得分80.2%,Multi-SWE-Bench达51.3%,BrowseComp获76.3%。推理速度比M2.1快37%,与Claude Opus 4.6相当,每小时仅需0.3-1美元,成本仅为同类模型1/10-1/20,为智能应用开发提供高效经济选择。【此简介由AI生成】Python00

MiniMax-M2.5MiniMax-M2.5开源模型,经数十万复杂环境强化训练,在代码生成、工具调用、办公自动化等经济价值任务中表现卓越。SWE-Bench Verified得分80.2%,Multi-SWE-Bench达51.3%,BrowseComp获76.3%。推理速度比M2.1快37%,与Claude Opus 4.6相当,每小时仅需0.3-1美元,成本仅为同类模型1/10-1/20,为智能应用开发提供高效经济选择。【此简介由AI生成】Python00 Qwen3.5Qwen3.5 昇腾 vLLM 部署教程。Qwen3.5 是 Qwen 系列最新的旗舰多模态模型,采用 MoE(混合专家)架构,在保持强大模型能力的同时显著降低了推理成本。00

Qwen3.5Qwen3.5 昇腾 vLLM 部署教程。Qwen3.5 是 Qwen 系列最新的旗舰多模态模型,采用 MoE(混合专家)架构,在保持强大模型能力的同时显著降低了推理成本。00- RRing-2.5-1TRing-2.5-1T:全球首个基于混合线性注意力架构的开源万亿参数思考模型。Python00