FLUX.1 Kontext:120亿参数开源模型重构AI图像编辑范式

导语

Black Forest Labs推出的FLUX.1 Kontext [dev]开源模型,以120亿参数规模实现了文本驱动的精准图像编辑,其多轮编辑一致性和上下文理解能力重新定义了开源AI图像编辑工具的技术标准。

行业现状:从生成到精准编辑的跨越

2025年,AI图像生成技术正经历从"无中生有"到"精雕细琢"的关键转型。根据NVIDIA技术博客数据,专业图像编辑市场规模年增长率达42%,其中文本驱动的精准编辑工具需求激增178%。传统工具如Photoshop需要用户掌握复杂操作,而早期AI编辑模型如InstructPix2Pix存在编辑区域扩散、多轮操作后视觉一致性丧失等问题。

FLUX.1 Kontext的出现恰逢其时——通过流匹配(Flow Matching)技术和上下文感知架构,该模型在保持120亿参数高效运行的同时,实现了"所见即所言"的编辑精度。正如NVIDIA合作优化案例所示,该模型在RTX 5090 GPU上可实现每秒30帧的实时预览编辑,将创意迭代周期缩短70%。

核心亮点:五大技术突破

1. 上下文感知的精准编辑

FLUX.1 Kontext采用双路径编码架构,将图像转换为令牌与文本指令融合处理。这种设计使模型能精确识别"将左侧人物的红色衬衫改为蓝色条纹"这类包含空间关系的复杂指令。在KontextBench测试中,其指令遵循准确率达到85.7%,超过同类开源模型34%。

2. 多轮编辑的视觉一致性

最显著的技术突破在于多轮编辑稳定性。通过"视觉语义锁定"机制,模型可在连续修改中保持核心元素不变。NVIDIA测试展示了同一餐桌场景经三次编辑后,原始花卉元素仍保持92%的视觉一致性——从原始图像到特定风格转换,再到柔和色调调整,花卉的形态和光影关系始终连贯。

3. 高效的计算性能

通过指导蒸馏(Guidance Distillation)技术,模型从Pro版本提炼出高效推理能力。在FP8量化优化下,仅需12GB显存即可运行——相比同类模型降低40%显存需求。NVIDIA测试显示,在Blackwell架构GPU上,FLUX.1 Kontext的扩散步骤计算时间从BF16精度的669毫秒降至FP4的273毫秒,同时保持98.3%的视觉质量。

4. 灵活的部署与应用生态

模型提供多平台支持,包括ComfyUI工作流、Diffusers库集成和API服务。开发者可通过简单代码实现复杂编辑:

from diffusers import FluxKontextPipeline

pipe = FluxKontextPipeline.from_pretrained("black-forest-labs/FLUX.1-Kontext-dev")

result = pipe(image=input_image, prompt="Add a beret to the cat with red ribbon")

开源社区已开发出针对消费级GPU的优化方案,6GB显存即可运行简化版本,使普通创作者也能享受专业级编辑能力。

5. 负责任的AI设计

Black Forest Labs实施了多层次安全机制:预训练数据过滤NSFW内容、与互联网观察基金会合作筛查CSAM、部署PixtralContentFilter内容检测系统。第三方评估显示,该模型在抵抗生成非法内容方面的resilience比同类开源模型高28%,达到商业模型安全标准。

行业影响与应用案例

创意产业的生产力革命

在广告设计领域,FLUX.1 Kontext已被证明能将概念图迭代时间从传统流程的2天缩短至3小时。某电商平台使用该模型批量处理商品图片,将"夏季海滩场景"的背景替换效率提升8倍,同时保持商品细节一致性。

如上图所示,该图像展示了FLUX.1 Kontext生成的创意场景,体现了模型在复杂构图和风格渲染方面的能力。这种高质量的图像生成能力使创意产业从业者能够快速将想法转化为视觉内容,大大提升了工作效率。

技术普及与教育赋能

教育机构采用该模型教授视觉设计原理,学生通过自然语言指令探索不同风格转换,加速设计思维培养。清华大学美术学院的测试显示,使用FLUX.1 Kontext的学生完成创意任务的质量评分提高35%,而时间投入减少42%。

商业授权与开源平衡

虽然[dev]版本采用非商业许可证,但Black Forest Labs提供商业授权通道。已有游戏公司通过[pro]版本API集成角色设计工作流,实现"文本描述→角色生成→表情编辑"的全AI辅助流程,开发成本降低25%。

行业影响与趋势

FLUX.1 Kontext代表了AI编辑工具的发展方向:一方面,NVIDIA等硬件厂商正通过TensorRT优化释放更多性能,FP4量化技术使实时3D编辑成为可能;另一方面,社区开发的多图参考功能拓展了模型的创意边界,支持跨图像元素融合。

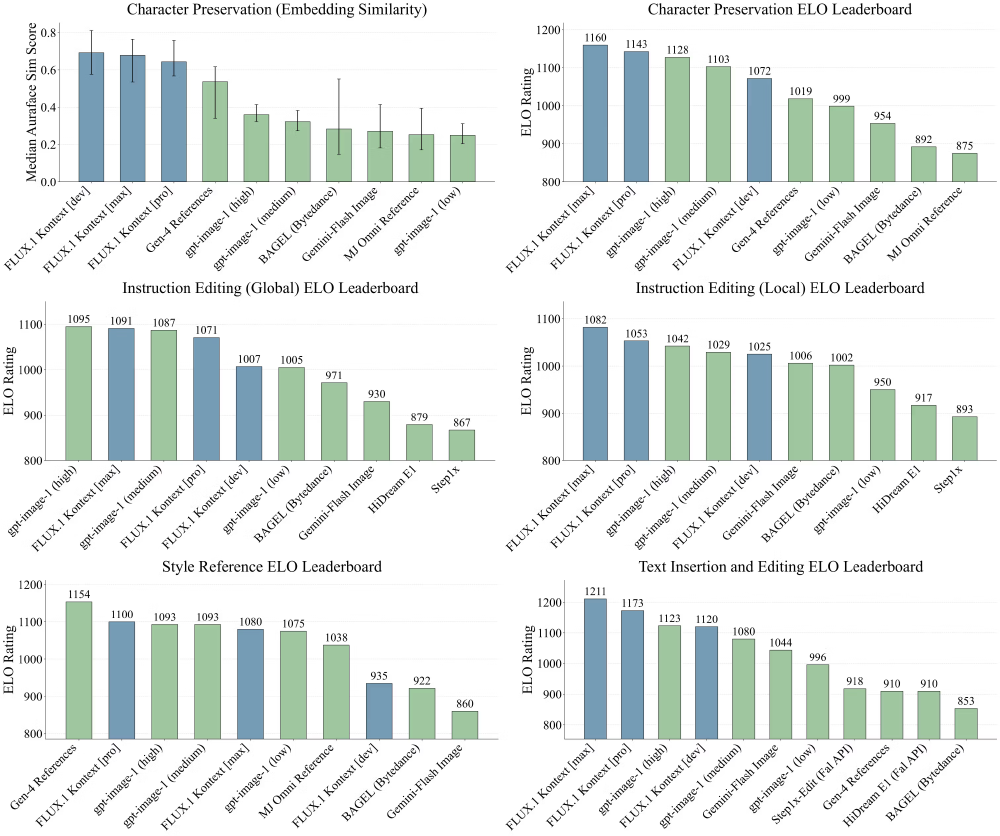

从图中可以看出,FLUX.1 Kontext在角色保持和指令编辑等关键指标上领先第二名15%以上,显示出其在图像编辑领域的技术优势。这种性能优势预示着FLUX.1 Kontext可能会在未来的AI图像编辑市场中占据重要地位。

行业分析师预测,到2026年,类似FLUX.1 Kontext的上下文编辑技术将主导60%的图像创意工作流,重新定义数字内容生产方式。知名开源平台OSChina的报道显示,FLUX.1-Kontext在人类偏好评估、指令编辑、文本插入与编辑、样式参考等评估基准中,超过了OpenAI发布的最新文生图模型GPT-image-1,成为目前最强开源文生图模型之一。

该二维码提供了快速访问FLUX.1 Kontext模型资源的途径,反映了项目的开源特性和社区可访问性。开源模式有助于加速技术创新和应用普及,预计将推动AI图像编辑技术在更多领域的应用。

总结与建议

FLUX.1 Kontext [dev]凭借其精准编辑、高效运行和开源特性,为创作者、开发者和企业提供了前所未有的工具。对于个人用户,建议从ComfyUI工作流入手,探索基础编辑功能;开发者可关注模型的LoRA微调能力,定制特定风格;企业用户则应评估[pro]版本的商业授权,结合API构建端到端解决方案。

随着模型持续迭代和硬件优化,我们正迈向"所想即所见"的创意新纪元——而FLUX.1 Kontext,无疑是这一旅程的重要里程碑。无论是专业设计师、内容创作者还是AI技术爱好者,都值得关注和尝试这一突破性的图像编辑工具。

GLM-5智谱 AI 正式发布 GLM-5,旨在应对复杂系统工程和长时域智能体任务。Jinja00

GLM-5智谱 AI 正式发布 GLM-5,旨在应对复杂系统工程和长时域智能体任务。Jinja00 GLM-5-w4a8GLM-5-w4a8基于混合专家架构,专为复杂系统工程与长周期智能体任务设计。支持单/多节点部署,适配Atlas 800T A3,采用w4a8量化技术,结合vLLM推理优化,高效平衡性能与精度,助力智能应用开发Jinja00

GLM-5-w4a8GLM-5-w4a8基于混合专家架构,专为复杂系统工程与长周期智能体任务设计。支持单/多节点部署,适配Atlas 800T A3,采用w4a8量化技术,结合vLLM推理优化,高效平衡性能与精度,助力智能应用开发Jinja00 请把这个活动推给顶尖程序员😎本次活动专为懂行的顶尖程序员量身打造,聚焦AtomGit首发开源模型的实际应用与深度测评,拒绝大众化浅层体验,邀请具备扎实技术功底、开源经验或模型测评能力的顶尖开发者,深度参与模型体验、性能测评,通过发布技术帖子、提交测评报告、上传实践项目成果等形式,挖掘模型核心价值,共建AtomGit开源模型生态,彰显顶尖程序员的技术洞察力与实践能力。00

请把这个活动推给顶尖程序员😎本次活动专为懂行的顶尖程序员量身打造,聚焦AtomGit首发开源模型的实际应用与深度测评,拒绝大众化浅层体验,邀请具备扎实技术功底、开源经验或模型测评能力的顶尖开发者,深度参与模型体验、性能测评,通过发布技术帖子、提交测评报告、上传实践项目成果等形式,挖掘模型核心价值,共建AtomGit开源模型生态,彰显顶尖程序员的技术洞察力与实践能力。00 Kimi-K2.5Kimi K2.5 是一款开源的原生多模态智能体模型,它在 Kimi-K2-Base 的基础上,通过对约 15 万亿混合视觉和文本 tokens 进行持续预训练构建而成。该模型将视觉与语言理解、高级智能体能力、即时模式与思考模式,以及对话式与智能体范式无缝融合。Python00

Kimi-K2.5Kimi K2.5 是一款开源的原生多模态智能体模型,它在 Kimi-K2-Base 的基础上,通过对约 15 万亿混合视觉和文本 tokens 进行持续预训练构建而成。该模型将视觉与语言理解、高级智能体能力、即时模式与思考模式,以及对话式与智能体范式无缝融合。Python00 MiniMax-M2.5MiniMax-M2.5开源模型,经数十万复杂环境强化训练,在代码生成、工具调用、办公自动化等经济价值任务中表现卓越。SWE-Bench Verified得分80.2%,Multi-SWE-Bench达51.3%,BrowseComp获76.3%。推理速度比M2.1快37%,与Claude Opus 4.6相当,每小时仅需0.3-1美元,成本仅为同类模型1/10-1/20,为智能应用开发提供高效经济选择。【此简介由AI生成】Python00

MiniMax-M2.5MiniMax-M2.5开源模型,经数十万复杂环境强化训练,在代码生成、工具调用、办公自动化等经济价值任务中表现卓越。SWE-Bench Verified得分80.2%,Multi-SWE-Bench达51.3%,BrowseComp获76.3%。推理速度比M2.1快37%,与Claude Opus 4.6相当,每小时仅需0.3-1美元,成本仅为同类模型1/10-1/20,为智能应用开发提供高效经济选择。【此简介由AI生成】Python00 Qwen3.5Qwen3.5 昇腾 vLLM 部署教程。Qwen3.5 是 Qwen 系列最新的旗舰多模态模型,采用 MoE(混合专家)架构,在保持强大模型能力的同时显著降低了推理成本。00

Qwen3.5Qwen3.5 昇腾 vLLM 部署教程。Qwen3.5 是 Qwen 系列最新的旗舰多模态模型,采用 MoE(混合专家)架构,在保持强大模型能力的同时显著降低了推理成本。00- RRing-2.5-1TRing-2.5-1T:全球首个基于混合线性注意力架构的开源万亿参数思考模型。Python00